16|2026 年最新 VS 2026 + CUDA 13.1 编译 llama.cpp 极致加速教程

在高性能显卡(如 RTX 4070 Ti Super)上本地运行大模型,编译环境的配置是第一道关卡。本文记录了在 Visual Studio 2026 和 CUDA 13.1 环境下成功构建 llama.cpp 的全过程。

一、 网络环境:开启全局代理

由于 Visual Studio 和 CUDA 的许多依赖项托管在海外服务器,网络波动会导致安装失败。

- 开启全局模式:确保你的代理软件处于“Global”模式。

- 系统级配置:进入 Windows“设置” -> “网络和 Internet” -> “代理”,确保“自动检测设置”开启。

- Installer 特殊处理:如果下载依然缓慢,可以在 VS Installer 的设置中勾选“使用系统代理”。

二、 环境重装:CUDA 13.1 深度集成

如果你之前遇到了 No CUDA toolset found,通常是因为安装顺序或路径识别问题。

- 驱动先行:确保显卡驱动版本在 590+ 以上。

- 卸载旧版:在“控制面板”中卸载所有带有 CUDA 11.x 或 12.x 字样的组件。

- 重装 CUDA 13.1:

- 从 NVIDIA 官网下载 exe (local) 离线包。

- 关键点:安装时选择“精简安装”,它会自动向 VS 2026 注入

BuildCustomizations文件。

- 手动补丁(CMake 仍报错):

- 将

C:\Program Files\NVIDIA GPU Computing Toolkit\CUDA\v13.1\extras\visual_studio_integration\MSBuildExtensions下的文件复制到: C:\Program Files\Microsoft Visual Studio\18\Community\MSBuild\Microsoft\VC\v180\BuildCustomizations。

- 将

三、 编译流程:针对 Ada 架构优化

使用 Developer Command Prompt for VS 2026 进入 llama.cpp 目录。

- CMake 配置(增加绕过编译器检查标志): ```cmd mkdir build cd build cmake .. -DGGML_CUDA=ON -DCMAKE_CUDA_FLAGS=”-allow-unsupported-compiler” -DCMAKE_CUDA_ARCHITECTURES=89

*注:`89` 是 4070 Ti Super 对应的架构代码。*

2. **并行构建**(利用 CPU 多核提速):

```cmd

cmake --build . --config Release -j 16

四、 对话脚本:Gemma-3 实测

编译完成后,使用以下脚本实现高效、不复读的中文对话。请将路径替换为你自己的模型路径。

**文件名:chat_gemma.bat**

@echo off

:: 设置字符集为 UTF-8 防止中文乱码

chcp 65001

:: 填写你的模型与可执行程序路径

set MODEL=D:\_code\ticktok_gen\models\gemma-3n-E4B-it-Q4_K_M.gguf

set EXE=D:\_code\llama.cpp\build\bin\Release\llama-cli.exe

:: 运行参数说明:

:: -ngl 99: 全力使用 GPU 显存

:: -c 8192: 8k 上下文长度

:: --temp 0.3: 降低温度,防止复读和逻辑发散

"%EXE%" -m "%MODEL%" ^

-ngl 99 ^

-c 8192 ^

--temp 0.3 ^

-cnv

pause

五、 运行表现与总结

在 RTX 4070 Ti SUPER 上,这套配置跑 Gemma-3-4B 的表现:

- Prompt 处理速度:约 55 t/s

- 生成速度 (Generation):稳定在 60 t/s 左右。

这种近乎瞬时的反馈速度,为本地开发优化提供了强大的算力基础。

根据您在 VS 2026 和 CUDA 13.1 环境下遇到的 cudafe++ 崩溃(Access Violation)问题,这里是为您博客准备的完整第六部分内容。这部分专门针对 Python 绑定的安装坑点进行了深度优化。

六、 进阶:安装 llama-cpp-python 实现 Python 调用

如果你需要将模型集成到 Web 项目(如 Flask 或 Django)中,则需要安装 llama-cpp-python 库。在 VS 2026 + CUDA 13.1 这种极新环境下,直接安装会触发 cudafe++ 内存访问冲突(0xC0000005),必须通过强制指定 64 位工具链来解决。

1. 环境准备

- 全局代理:确保环境依赖包下载不中断。

- 终端选择:必须使用 Developer Command Prompt for VS 2026,确保编译器环境变量处于活动状态。

2. 避坑指南:强制 64 位架构编译

默认情况下,CMake 可能会尝试调用 x86 兼容层工具链,这在 VS 2026 下极易导致 CUDA 编译器崩溃。我们必须在 CMAKE_ARGS 中明确指定 64 位主机架构。

在命令行中依次执行以下指令:

:: 1. 设置环境变量,关键在于 -A x64 和 -T host=x64

:: 这能强制 nvcc 使用 64 位工具链,绕过 cudafe++ died with status 0xC0000005 错误

set "CMAKE_ARGS=-DGGML_CUDA=on -DCMAKE_CUDA_FLAGS="-allow-unsupported-compiler" -DCMAKE_CUDA_ARCHITECTURES=89 -A x64 -T host=x64"

:: 2. 强制 CMake 重新配置

set FORCE_CMAKE=1

:: 3. 卸载旧版本并强制重新从源码编译安装

:: 使用 --verbose 观察日志,确认是否出现 "Found CUDA"

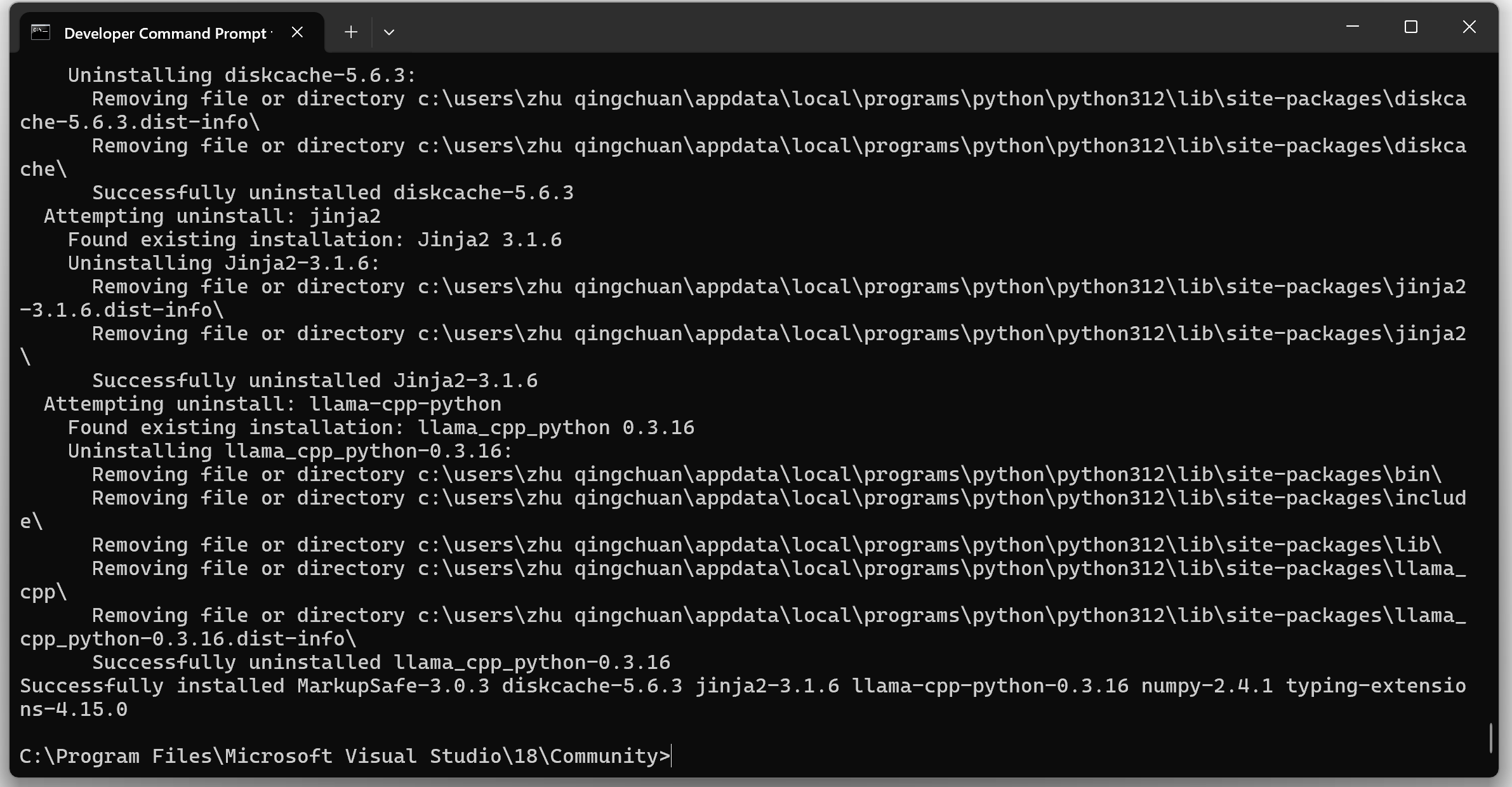

pip install llama-cpp-python --no-cache-dir --force-reinstall --verbose

3. 对话测试

安装完成后,在 Python 环境中运行以下脚本进行对话测试:

import os

from llama_cpp import Llama

# 1. 配置模型路径

MODEL_PATH = r"D:\_code\ticktok_gen\models\gemma-3n-E4B-it-Q4_K_M.gguf"

# 2. 初始化 Llama 实例

# n_gpu_layers=-1 表示将所有层卸载到 GPU

# n_ctx=8192 设置上下文长度

print("正在加载模型到 RTX 4070 Ti SUPER...")

llm = Llama(

model_path=MODEL_PATH,

n_gpu_layers=-1,

n_ctx=8192,

n_threads=12, # 匹配 i7-12700K 的核心数

verbose=True # 开启日志以确认 CUDA 是否生效

)

# 3. 对话循环

print("\n模型加载完成!请输入您的指令(输入 'exit' 退出)")

while True:

user_input = input("\n> ")

if user_input.lower() in ['exit', 'quit']:

break

# 使用 Gemma-3 格式创建对话

output = llm.create_chat_completion(

messages=[

{"role": "system", "content": "你是一个 AI 助手,请用中文回答。"},

{"role": "user", "content": user_input}

],

temperature=0.3,

stream=True # 开启流式输出

)

print("\n助手: ", end="")

for chunk in output:

delta = chunk['choices'][0]['delta']

if 'content' in delta:

print(delta['content'], end="", flush=True)

print("\n")

4. 技术小结

- ACCESS_VIOLATION 修复:该错误的核心在于 VS 2026 预览版工具链的路径选择,通过

-T host=x64强制指定 64 位宿主环境是目前的终极方案。 - 性能预期:通过 Python 调用时,处理速度应与原生 C++ 版本持平,保持在 60 t/s 左右的极速推理水平。